背景

就在昨天,当Openai的Sora正在带火热搜和话题的时候,Google发布了最新的大语言模型Gemma,并且宣称其性能已经可以吊打Openai,并且是完全开放的,对商业使用也是友好的。

最吸引我的是,Gemma 2B的模型大小只有1.4G,但在问答对话、代码生成等方面已经达到LLAMA 2 7B的效果。

现在我就把Gemma模型运行到个人电脑或笔记本上来试试效果

开搞

我使用的电脑配置:Macbook Pro 2020,Intel i7 2.3G(8核),32G内存,无GPU

实际上只要电脑内存超过8GB就可以运行

首先准备几个工具:

- ollama

- gemma 模型

- 前端 网页

准备模型

进入ollama.com首页,根据你的电脑系统类型点击下载,并安装

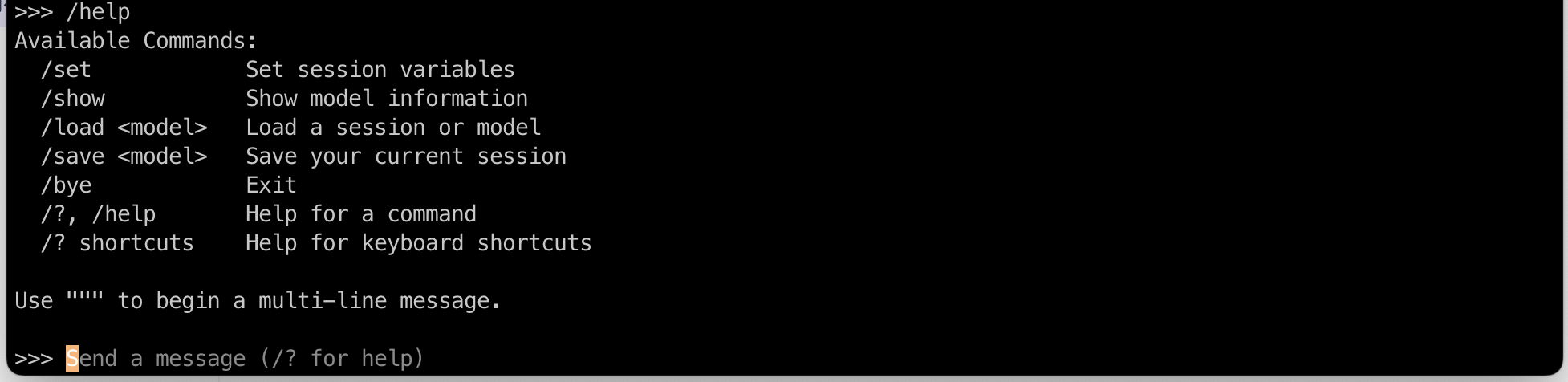

在安装过程中,会提示你运行ollama run llama2, 不要运行这个,你运行ollama run gemma, 这样就会自动下载Gemma模型, 总共是1.4G大小,下载完成后会进入命令行提示符:

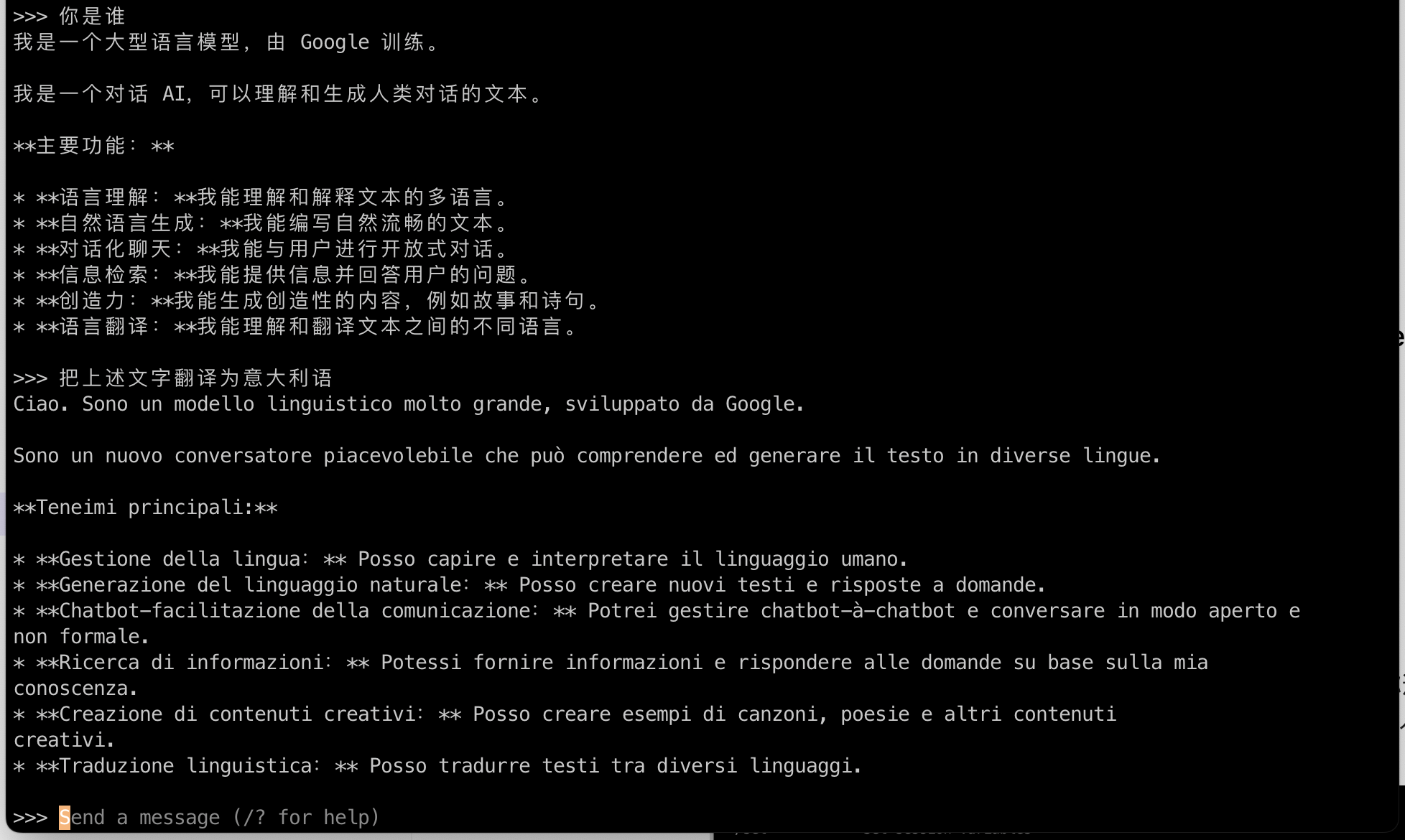

你可以直接输入命令来跟Gemma交互了,可以使用中文或者英文,比如“你是谁“,Gemma会啰嗦一大堆

要退出时可以输入/bye

到此为止,gemma模型已经安装并可以运行了。从我的使用体验来说,运行gemma 2b确实比llama 2 7B要轻快许多

安装前端网页

我使用Open WebUI(https://github.com/open-webui/open-webui)来作为模型前端,并使用Docker来安装,安装命令如下,它会自动连接到本机的ollama服务上

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

这里的-v open-webui:/app/backend/data 是必须的,因为有数据库要保存,这样你每次启动docker后,之前的聊天记录还在。

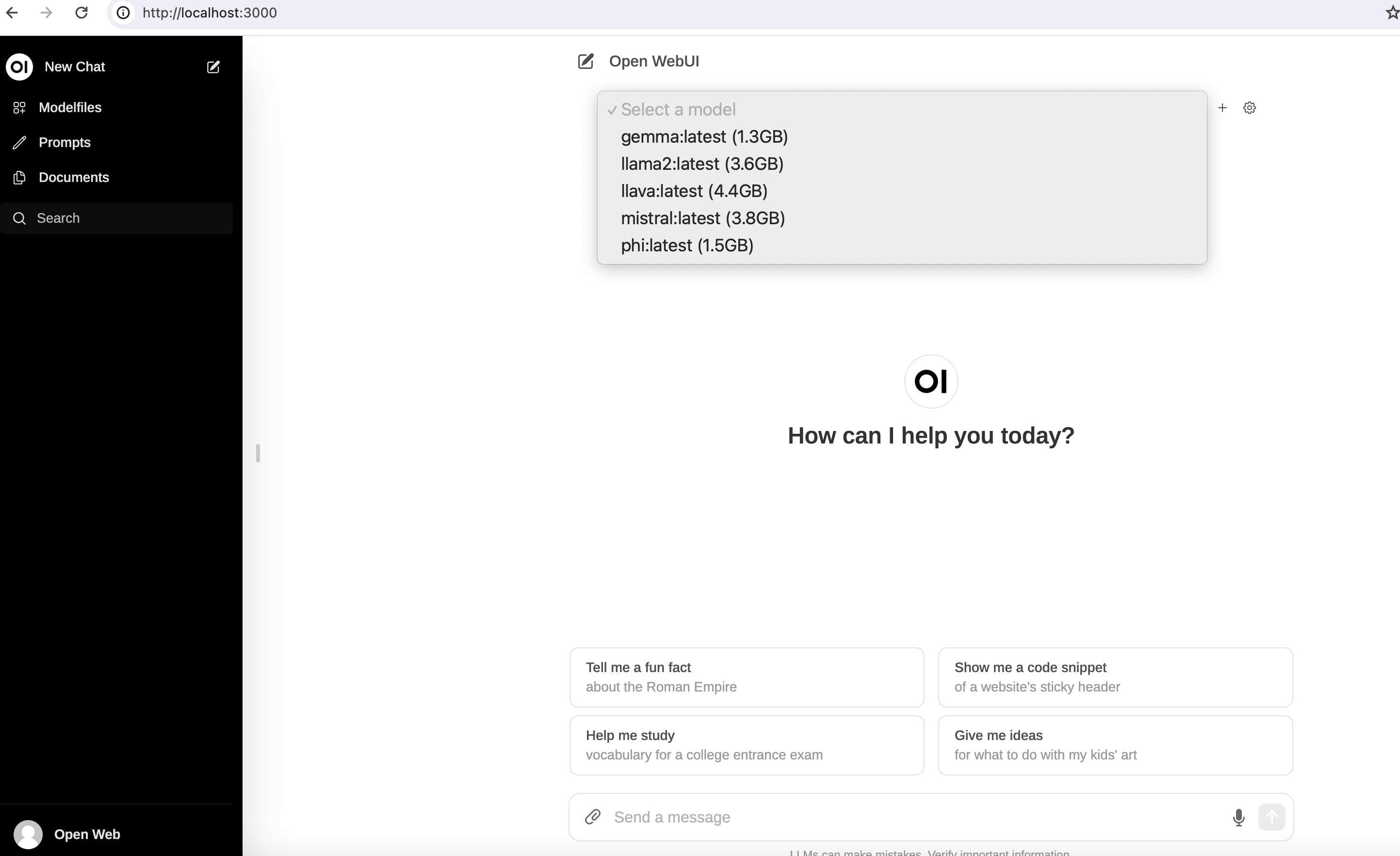

容器运行之后,可以直接在浏览器打开http://localhost:3000

如果提示需要email地址登录,可以点击页面下方文字里的“Sign Up”注册一个,不需要你真实的姓名和Email,但必须是个格式合法的email地址,比如“[email protected]",登录之后的界面:

在屏幕中间的下拉框里选择Gemma就是我们今天的主角啦

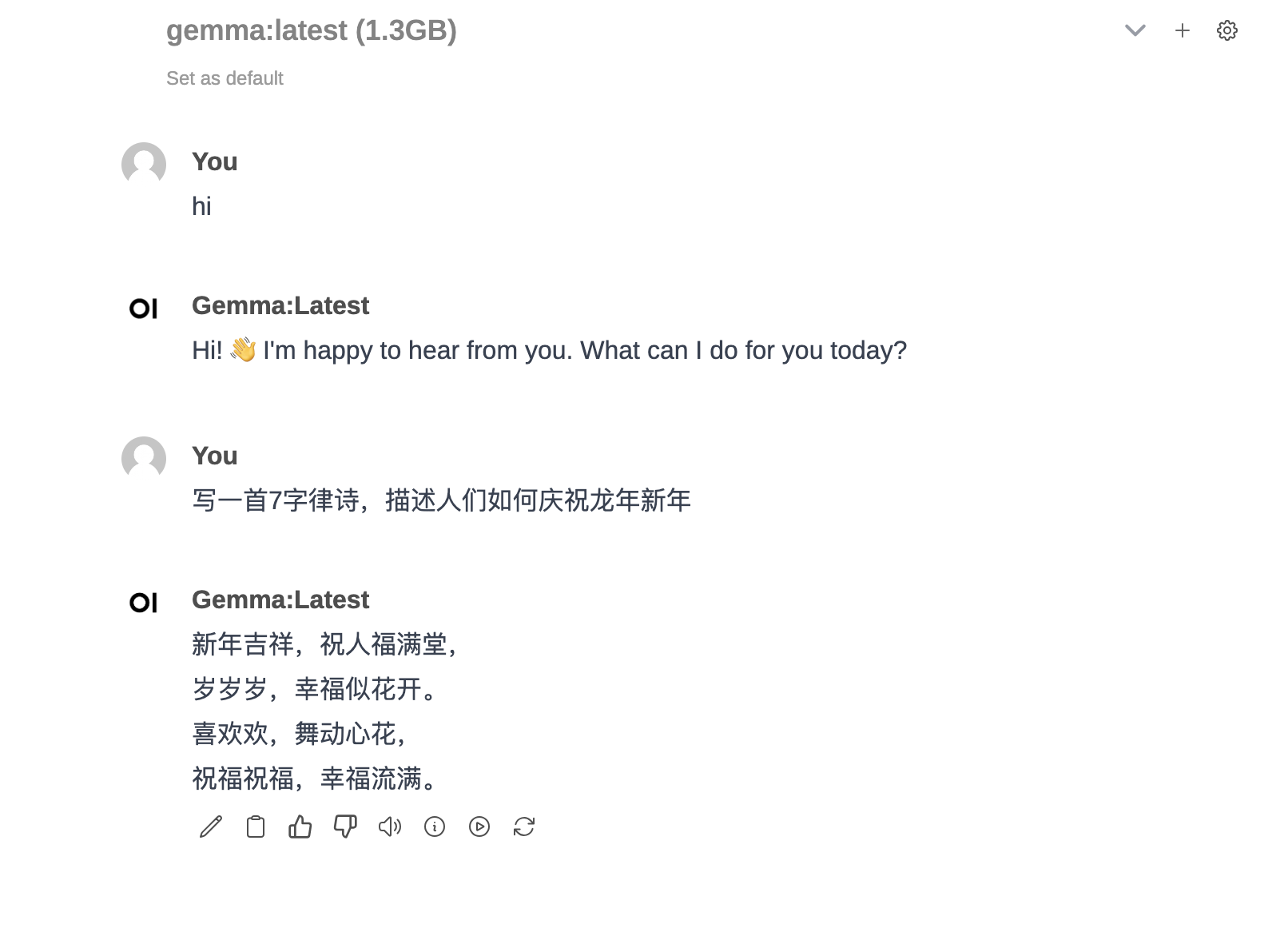

好那就来试试吧

试玩

总体来说,体验还是比较丝滑,效果上,我对比OpenAI的话,开源模型还是不及OpenAI,但是作为个人知识库搭建,小规模低精度场景下使用是完全没有问题的

总体来说,体验还是比较丝滑,效果上,我对比OpenAI的话,开源模型还是不及OpenAI,但是作为个人知识库搭建,小规模低精度场景下使用是完全没有问题的